11月7日凌晨,OpenAI在美国旧金山举办首届开发者大会,与来自全球的开发者、企业、合作伙伴分享了最新产品。微软首席执行官Satya Nadella作为特邀嘉宾出席了此次盛会。

会上,OpenAI发布了128K 上下文的GPT-4 Turbo、自定义GPT、DALL·E 3 API、全新Assistants API、视觉GPT-4 Turbo、JSON模式、GPT商店、ChatGPT Plus训练数据更新等一系列重磅内容。

其中,GPT-4 Turbo是本次大会的主打产品之一,成为OpenAI史上最强的ChatGPT。

下面作者根据OpenAI官网的正式发布,为大家解读首届开发者大会上的全部重要内容。

微软首席执行官Satya Nadella出席大会

早在今年3月OpenAI首次发布了GPT-4,并在7月向所有开发者开放了使用权限。现在,OpenAI发布了比前一代更强的——GPT-4 Turbo。(详细说明文档:https://platform.openai.com/docs/models)

所有付费开发者可以通过在API中发送gpt-4-1106-preview来尝试GPT-4 Turbo。OpenAI将在未来几周内发布稳定的准生产模型。

OpenAI联合创始人兼首席执行官介绍GPT-4 Turbo

GPT-4 Turbo具有128K上下文,相当于可一次性输入300多页文本内容10万汉字;训练数据知识截止至2023年4月;价格方面,GPT-4 Turbo与GPT-4相比,输入便宜3倍,输出便宜2倍。

GPT-4 Turbo还对函数调用和指令、JSON模式进行了调优。

函数调用更新:OpenAI发布了多项函数改进,包括在单个消息中调用多个函数的能力,用户可以发送一次请求多个操作的消息,例如“打开车窗并关闭空调”,这在以前需要与模型进行多次往返。

OpenAI还改进了函数调用的准确性,GPT-4 Turbo更有可能返回正确的函数参数。

指令遵循和JSON模式:与其他模型相比,GPT-4 Turbo在需要仔细遵循指令的任务上表现更好,例如“始终以XML格式响应”。

支持OpenAI最新的JSON模式,该模式确保模型将响应有效的JSON。(JSON模式介绍:https://platform.openai.com/docs/guides/text-generation/json-mode)

新的API参数response_format使模型能够限制其输出以生成语法正确的JSON对象。JSON模式对于开发人员在函数调用之外,在聊天完成 API 中生成 JSON 非常有用。

自定义GPT

OpenAI推出了自定义GPT版本,可以帮助金融、医疗、法律、教育、日常工作、幼儿教育等任何行业,例如,让ChatGPT教孩子如何学习3年级写作;让ChatGPT回答特定的技术内容等,打造独属自己的ChatGPT。

目前,OpenAI已经内置了很多定义GPT版本,用户可以直接选择使用或者自行构建。

介绍自定义GPT

用户构建的自定义GPT助手可以共享给其他人使用,目前该功能面向ChatGPT Plus和企业版用户。

可以将GPT助手集成在其他应用中:开发人员可以通过向 GPT 提供一个或多个 API 来定义自定义操作。

和插件一样,允许 自定义GPT 集成外部数据或与现实世界交互。将 GPT 连接到数据库,将其集成在电子邮件或成为购物助手。

GPT商店:本月晚些时候,OpenAI将会推出GPT商店功能,主要用于分享用户构建的自定义GPT助手,例如,法律助手、家庭常识助手、客服助手等。

一旦你构建的GPT助手审核通过进入GPT商店,就可以被其他人搜索到并且可能会登上排行榜。这意味着,用户可以通过构建自定义GPT助手赚钱了,就像苹果的APP商店一样。

ChatGPT Plus训练数据更新:现在,ChatGPT Plus的训练数据截至 2023 年 4 月,可以回答更多最新的内容了。

此外,用户无需进行频繁的DALL·E-3、网络浏览和高级数据分析的功能切换了ChatGPT将自行完成。支持用户上传文件,例如PDF、txt等,并基于文件内容进行提问、搜索。

带视觉功能的GPT-4 Turbo

GPT-4 Turbo可以接受图像作为聊天完成API中的输入,从而实现生成标题、详细分析现实世界图像以及阅读带有图片的文档等。例如,BeMyEyes已经使用这项技术帮助盲人或弱视人士完成日常任务。

开发者可以通过在API中使用gpt-4-vision-preview来尝试此功能。

OpenAI计划在GPT-4 Turbo模型正式发布时,将视觉功能集成在里面。定价取决于输入图像的大小。

例如,将1080×1080像素的图像传递给GPT-4 Turbo的成本为0.00765美元。

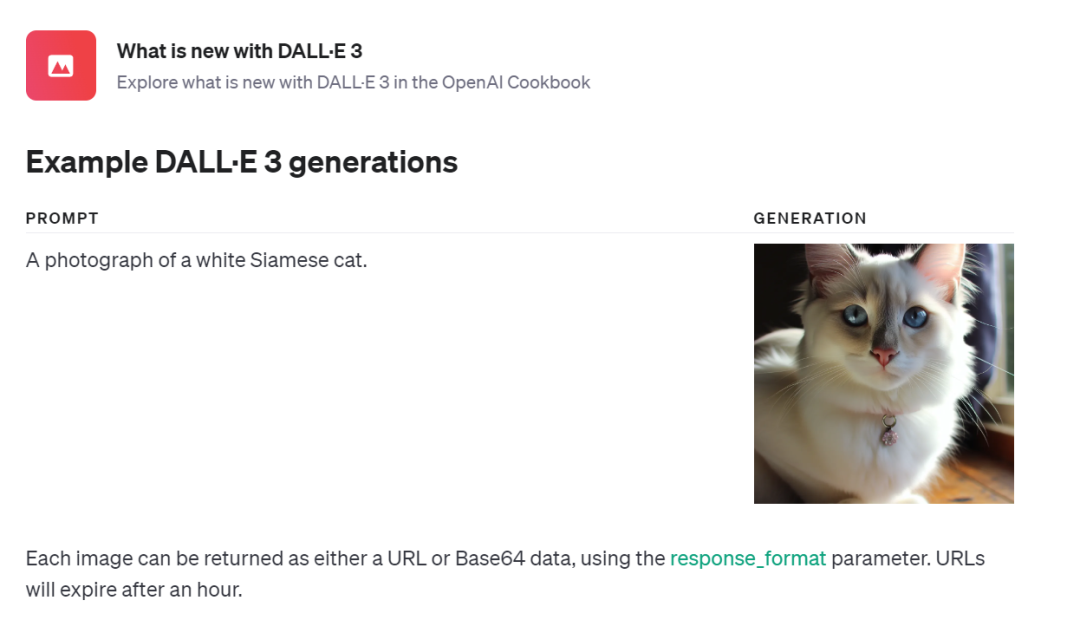

DALL·E 3 API

现在,开发人员可以通过API将文本生成图像模型DALL·E 3 直接集成到应用程序和产品中,价格从每张图像0.04美元起。(DALL·E 3介绍地址:https://platform.openai.com/docs/guides/images?context=node)

Snap、可口可乐和Shutterstock等公司已经开始在业务中使用DALL·E 3。

与之前版本不同的是,DALL·E 3 API集成了内置的内容审核功能,以帮助开发者防止其应用程序被滥用。

Assistants API

OpenAI发布了Assistants API,将允许开发者在自己的应用程序中构建 AI 助手,包括指令,可以利用模型、工具和知识来响应用户查询。(Assistants API详细地址:https://platform.openai.com/docs/assistants/overview)

目前Assistants API支持三种类型的工具:代码解释器、检索和函数调用。未来,OpenAI计划发布更多构建的工具,并允许开发者在其平台上提供自己的工具。

安全方面,开发者传递到 OpenAI API 的数据和文件永远不会用于训练模型,可以随时随地删除数据。

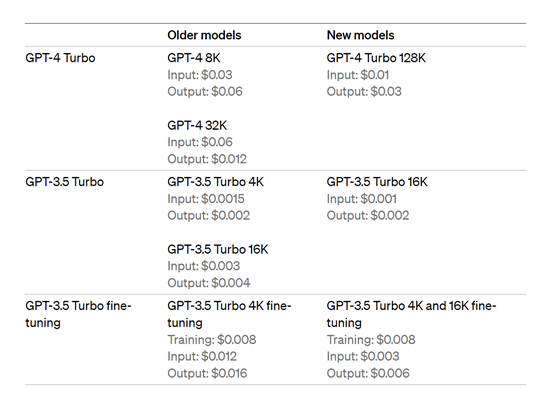

更低的价格

OpenAI再次下调了模型的价格,以帮助更多的开发者、企业节省成本。

GPT-4 Turbo输入代币比GPT-4便宜3倍,为0.01美元;输出代币便宜2倍,为0.03 美元。

最新款GPT-3.5 Turbo 输入代币比之前的16K型号便宜3倍,价格为 0.001 美元;输出代币便宜 2倍,价格为 0.002 美元。

之前使用 GPT-3.5 Turbo 4K 的开发人员受益于输入代币减少33%,价格为 0.001 美元。

经过微调的 GPT-3.5Turbo 4K 模型输入代币减少了 4 倍,价格为 0.003 美元,输出代币便宜了 2.7 倍,价格为0.006 美元。

致力于分享最及时的金融行业资讯

企业信息共享互动平台